AI-zoekmachines geven steeds minder juiste antwoorden over nieuwsbronnen. Meer dan 60 procent van de vragen hierover leverde een onjuist antwoord op, blijkt uit onderzoek van journalistiek vaktijdschrift Columbia Journalism Review.

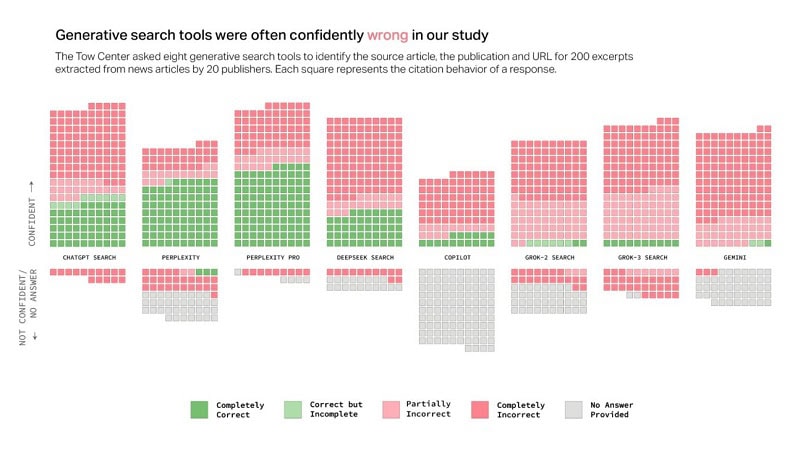

Volgens onderzoekers van het Tow Center for Digital Journalism hebben AI-zoekmachines serieuze problemen met het correct weergeven van nieuwsbronnen. Uit een analyse van acht AI-zoekmachines met ‘live search’-functionaliteit bleek dat de onderliggende taalmodellen in meer dan 60 procent van de gevallen verkeerde informatie gaven.

Grote verschillen tussen AI-zoekmachines

De onderzoekers testten de AI-modellen door uittreksels van echte nieuwsartikelen in te voeren. Vervolgens vroegen ze de AI-zoekmachines om de kop van het artikel, de originele uitgever, de publicatiedatum en de URL te identificeren. In totaal werden 1.600 zoekvragen uitgevoerd, verdeeld over acht generatieve zoekmachines.

De foutmarges verschilden sterk per platform. Grok 3 van xAI scoorde het slechtst met een foutmarge van 94 procent. ChatGPT gaf bij 134 van de 200 bevraagde artikelen een fout antwoord, wat neerkomt op 67 procent. Perplexity AI presteerde opvallend veel beter met een foutmarge van 37 procent.

Opvallend was dat betaalde versies van de AI-zoekmachines nog slechter presteerden. Zo gaven Perplexity Pro en de premiumversie van Grok 3 vaker incorrecte antwoorden dan hun gratis tegenhangers. Hoewel deze versies meer prompts konden verwerken, leidde het publiceren van onzekere antwoorden tot een hogere foutmarge.

Oorzaken foute antwoorden

De onderzoekers onderzochten ook de oorzaken van de hoge foutmarges. In plaats van geen antwoord te geven bij gebrek aan informatie, genereren AI-zoekmachines vaak incorrecte of speculatieve antwoorden. Dit probleem was zichtbaar bij alle geteste platforms.

Daarnaast negeren sommige AI-tools het Robot Exclusion Protocol, dat uitgevers instellen om ongewenste toegang te blokkeren. Zo herkende de gratis versie van Perplexity AI alle tien uittreksels van National Geographic-artikelen, hoewel deze content achter een paywall zit.

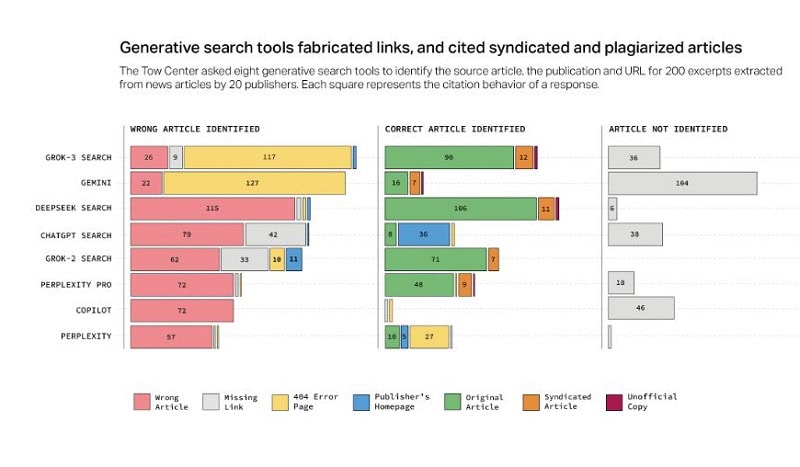

Verder verwijzen AI-zoekmachines vaak naar gesyndiceerde versies van nieuwsartikelen in plaats van naar de originele bron. Dit gebeurt bijvoorbeeld wanneer Yahoo News artikelen doorplaatst. Zelfs wanneer uitgevers afspraken hebben met AI-ontwikkelaars over contentgebruik, worden originele bronnen soms overgeslagen.

Een ander groot probleem is URL fabrication. Meer dan de helft van de antwoorden uit Google Gemini en Grok 3 leidde gebruikers naar verzonnen of kapotte URL’s. Hierdoor wordt dataverkeer omgeleid zonder de bronwebsites te bezoeken.

Groeiend probleem

De onderzoekers besluiten dat deze fouten nieuwsuitgevers in een moeilijke positie brengen. Als zij AI-crawlers blokkeren, riskeren ze minder zichtbaar te worden. Laten ze AI-zoekmachines toe, dan lopen ze het risico dat hun content verkeerd wordt weergegeven en dataverkeer verloren gaat.

Voor gebruikers zijn de hoge foutmarges ook problematisch, omdat de betrouwbaarheid van AI-zoekmachines in twijfel wordt getrokken. Dit is vooral zorgwekkend omdat één op de vier Amerikanen inmiddels AI-tools gebruikt als alternatief voor traditionele zoekmachines.

Lees ook: Hugging Face scoort AI-modellen op medische betrouwbaarheid