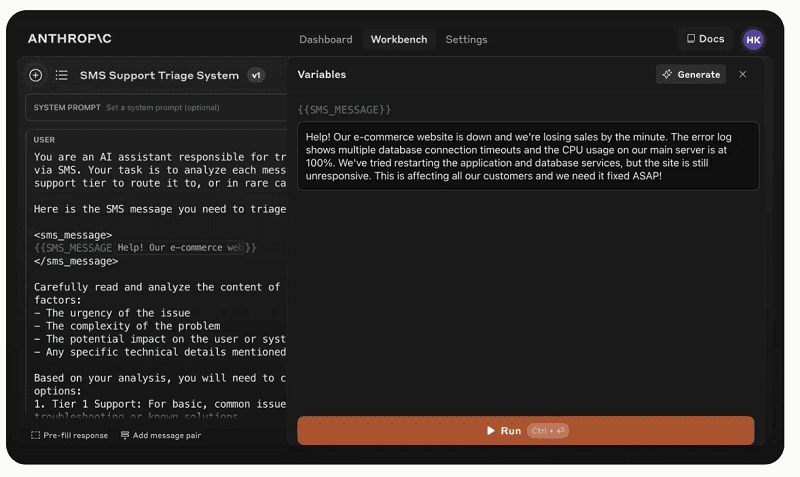

Interacties met de Claude-3 LLM’s van Anthropic moeten voor ontwikkelaars een stuk makkelijker worden met nieuwe features in Anthropic Console. De AI-ontwikkelaar biedt nu functionaliteit die automatisch gegenereerde prompts test en evalueert op hun effectiviteit.

Het maken van de juiste prompts of zoekvragen is de beste garantie om de meeste waarde uit LLM’s te halen. Anthropic wil eindgebruikers hierbij flink helpen door automatisch gegenereerde prompts te testen en te evalueren op hun effectiviteit.

Voor zijn Claude 3.5 Sonnet-LLM biedt de AI-ontwikkelaar hiervoor nu in zijn Anthropic Console-interface nieuwe functionaliteit. Op termijn kunnen ontwikkelaars op basis van de feedback betere inputs realiseren en daarmee de antwoorden van het Claude-LLM voor gespecialiseerde taken verbeteren.

Gebruiksmogelijkheden

Meer specifiek helpt de nieuwe omgeving gebruikers met het testen en evalueren van de prompts die gemaakt werden door de ingebouwde prompt generator, die in mei dit jaar introduceerde. Hiermee kunnen zij de effectiviteit van deze prompts in verschillende scenario’s testen. Gebruikers vinden dit onder de Evaluate-tab in de interface.

Daarnaast kunnen zij eigen voorbeelden naar de testomgeving uploaden of het Claude 3.5 Sonnet-LLM vragen een reeks van AI-gegenereerde test cases te produceren. Op deze manier kunnen ontwikkelaars verschillende prompts naast elkaar vergelijken in effectiviteit en deze voorbeelden een rating op een schaal van één tot vijf geven.

De testomgeving is nu per direct beschikbaar voor alle eindgebruikers van de Anthropic Console.

Lees ook: Anthropic start initiatief voor betere benchmarks voor LLM’s