De nieuwe versie is betaalbaarder en kent minder latency, waardoor meer mensen gebruik kunnen maken van het krachtige model van ChatGPT-maker OpenAI.

Een kleiner model kan aantrekkelijk zijn voor onderzoekers en ontwikkelaars. Zij kunnen bijvoorbeeld bij het bouwen van applicaties de voorkeur geven aan zo’n type model vanwege de lagere compute-kosten en hogere snelheden. Zo’n kleine versie gebruikt minder parameters dan de grotere variant. Dat kleinere aantal parameters is in verschillende situaties meer dan voldoende om eenvoudigere taken uit te voeren.

GPT-4o mini, zoals het model heet, is bijvoorbeeld in te zetten voor applicaties die meerdere modelaanroepingen aan elkaar koppelen of parallelliseren. Ook voor het doorgeven van een grote hoeveelheid context aan het model of het communiceren met gebruikers via snelle reacties is GPT-4o mini geschikt.

Prestaties

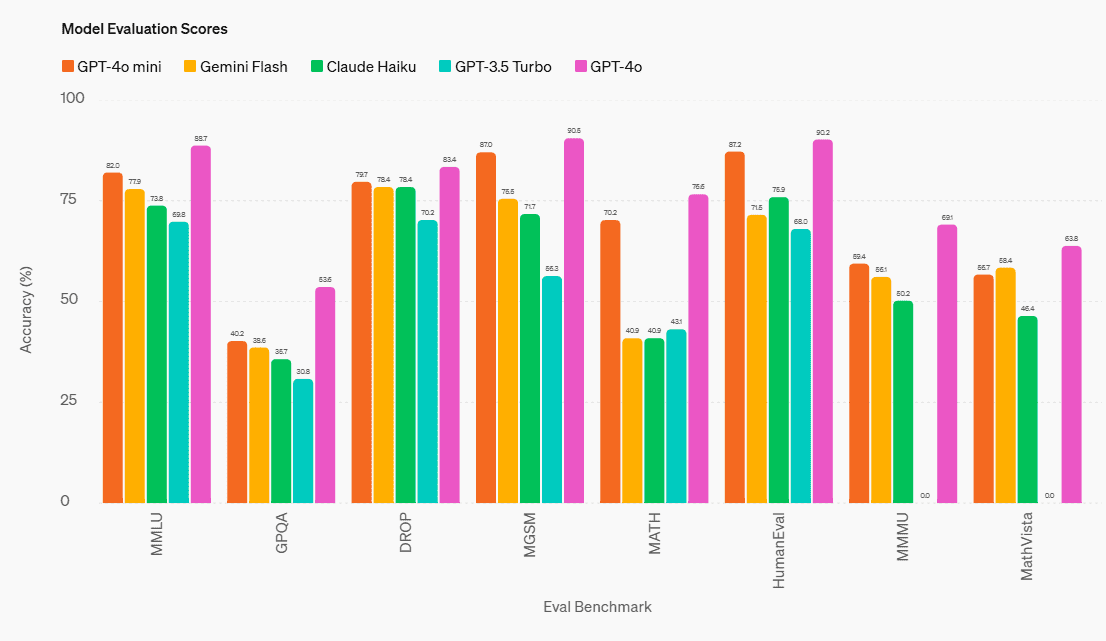

OpenAI heeft bij het beschikbaar maken ook benchmarks gepubliceerd om de capaciteiten te tonen. Het overtreft andere kleine modellen op het gebied van tekstuele intelligentie en multimodaal redeneren. Daarnaast laat het sterke prestaties zien bij het aanroepen van functies. Dat is gunstig voor ontwikkelaars die apps bouwen waarbij data opgehaald worden of interacties met externe systemen plaatsvinden. Hieronder een overzicht van de benchmarks.

Op het gebied van redenering is de MMLU-benchmark belangrijk. Daar scoort GPT-4o mini 82 procent, aanzienlijk beter dan concurrenten Gemini Flash (77,9 procent) en Claude Haiku (73,8 procent). Voor wiskundige taken en coderen zijn de MGSM- en HumanEval-benchmarks leidend, en ook op dat vlak presteert het nieuwe model van OpenAI hoger. Tot slot vinden we de MMMU nog nuttig om uit te lichten, die als standaard dient voor multimodaal redeneren. Daar zit GPT-4o mini tegen de 60 procent aan, terwijl Flash en Haiku respectievelijk 56,1 procent en 50,2 procent behalen.

Voor gebruikers van ChatGPT Free, Plus en Team is GPT-4o mini per direct beschikbaar. Enterprise-gebruikers volgen volgende week. Ontwikkelaars betalen 15 cent per 1 miljoen input tokens en 60 cent per 1 miljoen output tokens.