Stel je een wereld voor waarin machines ons niet alleen begrijpen, maar ook helpen bij het ontwikkelen, voorspellen en hervormen van complete sectoren. Dit is geen sciencefiction, maar de realiteit van kunstmatige intelligentie (AI). En AI verweeft zich snel in ons dagelijks leven.

Van de manier waarop we smartphones gebruiken tot wetenschappelijke ontdekkingen en bedrijfsapplicaties – de invloed van AI blijft groeien. Dit komt door de innovaties in AI-hardware en -software-infrastructuur, evenals large language models (LLM’s). Laten we ons eens richten op het begrijpen van die AI-infrastructuur, en dan vooral de onderliggende netwerken.

De AI-levenscyclus

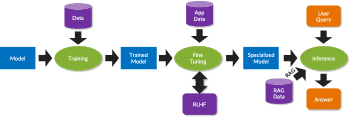

De AI-levenscyclus begint met training. In tegenstelling tot traditionele computers, waar programma’s vooraf gecodeerde logica volgen, leren GenAI-applicaties de logica van enorme datasets die tijdens de trainingsfase worden ingevoerd in een large language model. Dit proces omvat neurale netwerken, die verwant zijn aan de neuronen in het menselijk brein. Ze passen wiskundige functies (activeringsfuncties) toe op de gewogen som van hun inputs (parameters) om outputs te genereren. Met behulp van GPU’s en xPU’s worden enorme hoeveelheden gegevens (de outputs) uitgewisseld tussen knooppunten in een neuraal netwerk, waardoor het netwerk een integraal onderdeel wordt van de AI-infrastructuur.

Zodra modellen getraind zijn met generieke data worden ze verfijnd met specifieke gegevens om de nauwkeurigheid, relevantie en effectiviteit te verbeteren. Vaak wordt het zogenoemde ‘reinforced learning from human feedback’ (RLHF) gebruikt om vooringenomenheden en fouten te corrigeren. Het gespecialiseerde model maakt soms gebruik van retrieval-augmented generation (RAG) om de nauwkeurigheid en relevantie van antwoorden te verbeteren.

Een AI-oplossingsstack bouwen

Een effectieve AI-oplossingsstack bestaat uit verschillende lagen, die allemaal belangrijk zijn voor de algehele functionaliteit. Bovenaan staan AI-toepassingen en -agenten die use case- en domeinspecifieke functionaliteit bieden. Ze zijn gebouwd boven op LLM’s, zoals ChatGPT, Gemini of Llama. Ze kunnen menselijke taal begrijpen en erop reageren door enorme hoeveelheden tekst, afbeeldingen, audio en video te verwerken.

Deze applicaties worden ondersteund door een robuuste software-infrastructuur, waaronder machine learning frameworks zoals PyTorch en TensorFlow. Ze voorzien ontwikkelaars van tools waarmee ze modellen eenvoudig kunnen ontwikkelen en trainen. Dit omvat ook bibliotheken en compilers, zoals NumPy, die geoptimaliseerd zijn voor matrixbewerkingen voor specifieke GPU/xPU. Platformsysteemsoftware, waaronder besturingssystemen, containers, orchestrators, clustersoftware, schedulers en monitoringsoftware vallen, speelt een belangrijke rol bij het automatiseren en beheren van de machine learning-levenscyclus.

De hardware-infrastructuur vormt de basis van de AI-stack. Deze is opgebouwd uit reken-, opslag- en netwerkinfrastructuur. Compute omvat AI-servers met versnellers (GPU/xPU), CPU’s, High Bandwidth Memory (HBM) en krachtige netwerkinterfaces. Opslagsystemen worden gebruikt om gegevens naar de GPU’s/xPU’s te sturen en om tussentijdse resultaten te controleren om ze tegen storingen te beschermen. De GPU’s/xPU’s in deze servers laden het model en de gegevens in HBM, voeren wiskundige functies uit en produceren resultaten. Deze worden vervolgens uitgewisseld tussen de GPU’s/xPU’s via een zeer schaalbaar netwerk met low latency. Tijdens de trainingsfase herhaalt deze cyclus van rekenen en communiceren zich dagen tot weken.

Waarom een netwerkinfrastructuur belangrijk is voor AI

Een netwerkinfstrastructuur speelt een cruciale rol in AI-clusters en ondersteunt de gedistribueerde architectuur die nodig is voor AI-werkloads. Tegenwoordig zijn AI-servers verantwoordelijk voor meer dan 80% van de totale AI-infrastructuurkosten. Vertragingen in netwerkcommunicatie kunnen ertoe leiden dat dure AI-servers niet volledig benut worden. Hierdoor worden de algehele prestaties en kosteneffectiviteit beïnvloed. Tijdens de OCP Summit in 2022 gaf Meta aan dat bepaalde modellen tot 57% van hun tijd besteden aan wachten tot de netwerkcommunicatie is voltooid. Dit benadrukt de noodzaak van een krachtig low latency netwerk om de job completion time (JCT) te verlagen en de prestaties van AI-applicaties te verhogen.

Omdat AI-training veel rekenkracht vereist en niet kan worden uitgevoerd zonder een schaalbare architectuur, gebruiken AI-algoritmen parallelle technieken om performance te leveren. Dit doen ze door data te verdelen over meerdere GPU’s/xPU’s en modelberekeningen te verdelen over meerdere AI GPU’s/xPU’s voor efficiëntie. Bij deze aanpak moeten AI-servers periodiek via het netwerk communiceren en wachten tot de communicatie in elke fase is voltooid.

Het gebruik van parallellisme vereist een gigantische hoeveelheid aan gegevensuitwisselingen tijdens het trainen met behulp van Remote Direct Memory Access (RDMA). Dit veroorzaakt enorme netwerkstromen, ook wel ‘elephant flows’ genoemd, en potentiële overbelasting van het netwerk. Een betrouwbaar netwerk met geavanceerde mogelijkheden voor load balancing en congestiebeheer is belangrijk om de efficiëntie, prestaties en betrouwbaarheid van AI-clusters te waarborgen.

Omdat het trainen van AI-modellen gepaard gaat met het binnenhalen van enorme hoeveelheden gegevens, moeten deze efficiënt worden opgeslagen en gebruikt. ‘Checkpointing’ – het maken van periodieke momentopnames van de trainingsvoortgang van het model – is cruciaal voor weerbaarheid tegen hardwarestoringen. Het biedt ook de mogelijkheid om te experimenteren en biedt een mechanisme om debuggen makkelijker te maken.

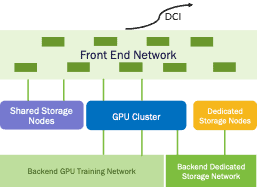

AI-clusters hebben meestal meerdere netwerken, elk met een eigen doel. Het front-end netwerk verbindt de AI-server met de rest van het datacenter en de buitenwereld en helpt gebruikers om verbinding te maken met het AI-cluster. De datacenter interconnect (DCI) verbindt meerdere datacenters met AI-clusters voor hoge beschikbaarheid en weerbaarheid. Het scale-out netwerk wordt gebruikt voor ‘gradient exchange’ tijdens training. Het backend opslagnetwerk verbindt AI-servers met hoogwaardige storage. Klanten gebruiken hiervoor bij voorkeur Ethernet. Tot slot verbindt het scale-upnetwerk veel AI-servers binnen een chassis of rack met een cache-coherent, leverancier-specifiek netwerk met hoge bandbreedte, zoals NVLink van Nvidia en Infinity Fabric van AMD. Recentelijk is een op open standaarden gebaseerd alternatief genaamd UALink (Ultra Accelerator Link) op de markt gekomen met brede steun vanuit de industrie.

De AI-innovatie gaat in rap tempo verder

De sector staat nog in de kinderschoenen, maar ontwikkelt zich snel dankzij investeringen om de nauwkeurigheid, prestaties en energie-efficiëntie van AI-modellen te verbeteren. Denk aan investeringen op gebieden, zoals geavanceerd gegevensbeheer, modeloptimalisatie/ selectie, continu leren, algoritmen, software en hardware.

Naast technologische overwegingen zijn het ethisch gebruik van AI en het voorkomen van misbruik ervan belangrijke aandachtspunten. Florerende consortia, zoals MLCommons, UALink, Ultra Ethernet Consortium, en initiatieven, zoals Pytorch en het Triton-project, zullen een vitale rol spelen bij het bevorderen van samenwerking en innovatie. Ze helpen bovendien bij het aanpakken van zorgen en voldoen aan behoeften van klanten.

Dit is een ingezonden bijdrage van Juniper Networks. Via deze link vind je meer informatie over de mogelijkheden van het bedrijf.