Volgens The Information bereidt Cerebras heimelijk een beursgang voor. Wat doet het bedrijf precies en waarom wordt het veelvuldig tot ‘Nvidia-uitdager’ gebombardeerd?

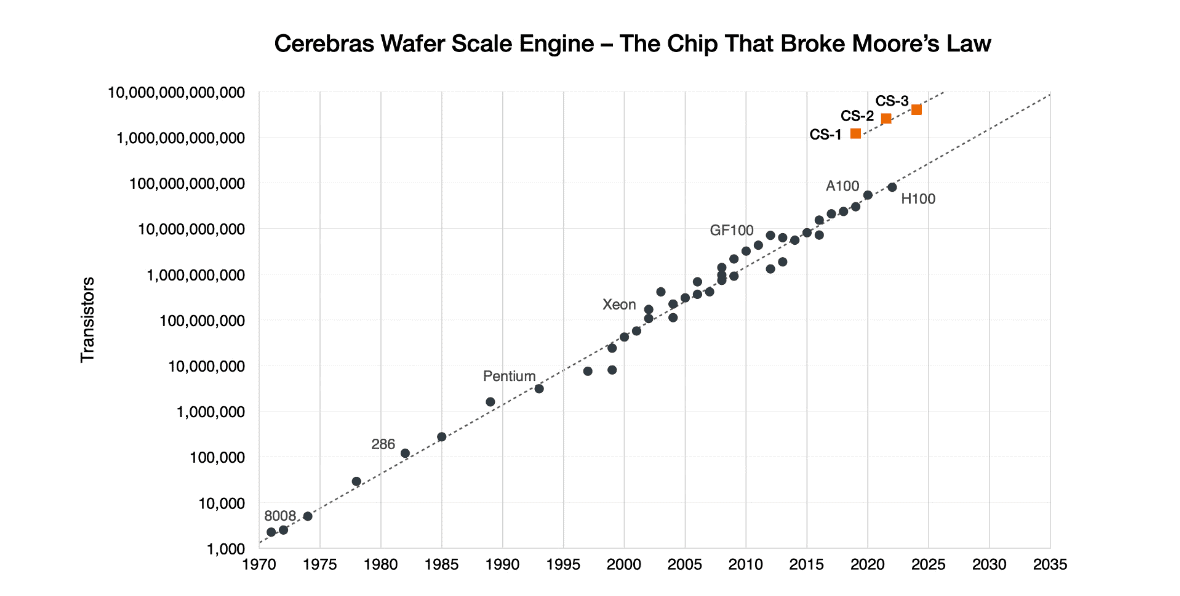

Daar waar Nvidia, Intel en andere chipbedrijven producten maken die nauwelijks groter zijn dan een postzegel, zijn deze bij Cerebras zo groot als een borstkas. Met 4 biljoen(!) transistoren, 900.000 cores en 125 petaflops aan AI-compute is de meest recente Cerebras Wafer-Scale Engine (WSE-3) de “snelste AI-chip ter wereld”, zoals het bedrijf in maart aangaf. In totaal zijn er 2.048 aan elkaar te koppelen, waardoor de totale rekenkracht uitkomt op 256 Exaflops. Bij Nvidia zijn er tienduizenden gloednieuwe Blackwell-GPU’s nodig om dat theoretische aantal te behalen.

Echter is Nvidia de mondiale AI-chipmaker waar niemand om heen kan. Diens GPU’s vullen overal datacenters en kosten door schaarste tienduizenden euro’s per stuk, terwijl er talloze nodig zijn om op grote schaal AI te trainen. Wat hebben potentiële klanten aan het alternatief vanuit Cerebras? En wie zijn die klanten?

Use cases: farmaceuten, academici, supercomputers

Ten opzichte van voorganger WSE-2 belooft Cerebras met versie 3 een snelheidsverdubbeling in AI-training. Dat klinkt als iets waar een Microsoft, AWS of Google Cloud van opkijkt, maar die partijen worden niet door Cerebras als klanten aangestipt. De AI-chipmaker haalt allerlei andere organisaties aan, maar er is telkens één overeenkomst: de inzet is zeer specifiek.

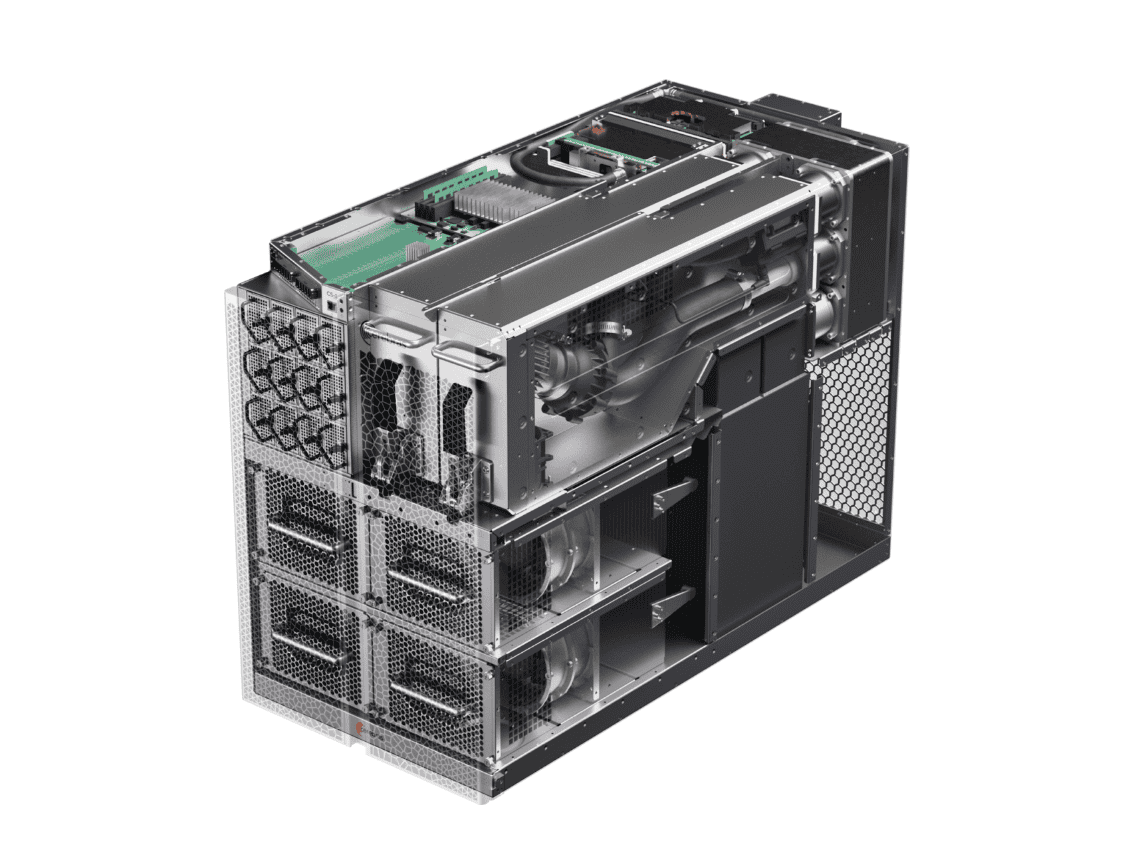

Elke Cerebras-chip wordt verpakt in een CS-systeem, waarbij het nummer erna verraadt welke versie van de Wafer Scale Engine in gebruik is. Zo heeft farmaceut AstraZeneca, bekend bij het grote publiek voor het eigen Covid-vaccin, een CS-1 ingezet om duizenden onderzoekspapers razendsnel door AI te laten analyseren. Naar eigen zeggen ging de trainingstijd door de inzet van een CS-1 van twee weken naar twee dagen.

Andere klanten zijn onder meer het Amerikaanse National Laboratory, TotalEnergies Research en een niet nader genoemd prominent financieel instituut in de VS. Kortom: gebruikers met een helder, domein-specifiek doel en een sterke eis om workloads zo snel mogelijk te laten draaien. Ondanks het feit dat elk systeem meerdere miljoenen euro’s kost, stelt Cerebras dat klanten alsnog veel goedkoper uit zijn dan als ze bij Nvidia of elders hadden aangeklopt. Daarbovenop eist een enkele CS-1, -2 of -3 een fractie van de beschikbare ruimte in een datacenter op, terwijl Nvidia geïnteresseerden aanspoort om het gehele ontwerp van datacenters overhoop te gooien.

Wafer-scale

Zoals de WSE-3-naamgeving al aangeeft, zijn Cerebras-chips ‘wafer-scale’. Daar waar een partij als Nvidia honderden werkbare GPU’s met een enkele silicium wafer van 300mm kan bakken, vult een enkele WSE-3 de gehele wafer. Wafers hebben echter altijd een foutmarge: defecten komen zelden, maar regelmatig voor. Dit komt door miniscule fouten in fabricagemachines, die soms slechts enkele nanometers naast de bedoelde plek op de chip tekenen. Kortom: een enkel stootje zorgt al voor problemen. Voor Nvidia betekent dit dat het enkele GPU’s moet weggooien, maar voor Cerebras zou het in theorie betekenen dat de gehele wafer onbruikbaar is. Toch zorgt het er met een redundante 1,5 procent aan extra cores voor dat de opbrengst goed uitpakt. Het overgrote merendeel, bijna 100 procent, van de potentiële WSE-3’s komen heelhuids door de TSMC-productielijn en ASML-machines heen.

Omdat een enkele Cerebras-chip een enkele wafer beslaat, is de interne communicatie vele malen sneller dan wanneer meerdere GPU’s met elkaar communiceren. Met 880 keer de hoeveelheid on-chip geheugen en 7.000 keer de geheugenbrandbreedte laat een Cerebras WSE-3 de H100-chip van Nvidia alle hoeken van het veld zien. Interne chiptechnologie kan simpelweg stukken sneller schakelen dan welk extern communicatiemiddel dan ook, of dat nu PCIe 5.0, NVLink of Ethernet is.

In tegenstelling tot de AI-chips van Intel en AMD belooft Cerebras een fundamenteel ander prestatieniveau dan Nvidia. Toch is de Amerikaanse partij vooralsnog een uitdager in de chipindustrie, zoals men mag verwachten bij een bedrijf dat pas acht jaar oud is. Ingezetene Nvidia rust op een reusachtig ecosysteem aan partners, software en de eigen hardware om aan kop te blijven. Cerebras herinnert ons er graag aan dat het als enige de wet van Moore in stand houdt. Kortom: het weet als enige elke twee jaar het aantal transistoren per chip te verdubbelen. Of pure prestaties ook de schaal zullen leveren die Cerebras een echte Nvidia-uitdager maakt, moet de verwachte beursgang later dit jaar bewijzen.